跟踪中国操作系统发展动态,向世界宣传中国操作系统,中国信创产业一定会成功!

图解Windows10+优麒麟双系统安装

为防止超速翻车,建议通读全文后再进行操作。

(此处双系统以 Windows 10+优麒麟 20.04 LTS Pro 为例,其他版本的系统仅供参考)

01

安装前的准备

四小步

第一步:查看电脑基础信息

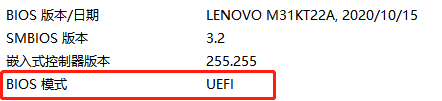

按”win+r”快捷键回车确认,输入”msinfo32″,回车,出现系统信息界面,可查看 BIOS 模式:

BIOS 有多种模式,此教程以 UEFI 模式为例;

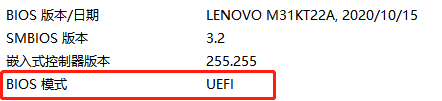

第二步:下载优麒麟镜像

官网下载:(www.ubuntukylin.com/downloads/)

页面下方还有多个开源镜像站下载途径可供选择;

注:下载完成后,为确认优麒麟系统镜像的完整性,可以使用 MD5 校验工具(网页搜索下载即可)验证 MD5 值与官网的是否一致。

第三步:准备一个 U 盘

打开冰箱门,拿出一个新鲜的U盘(或移动硬盘、DVD,此处以 U 盘为例)插在电脑上

要求:U 盘内存大于 4G;

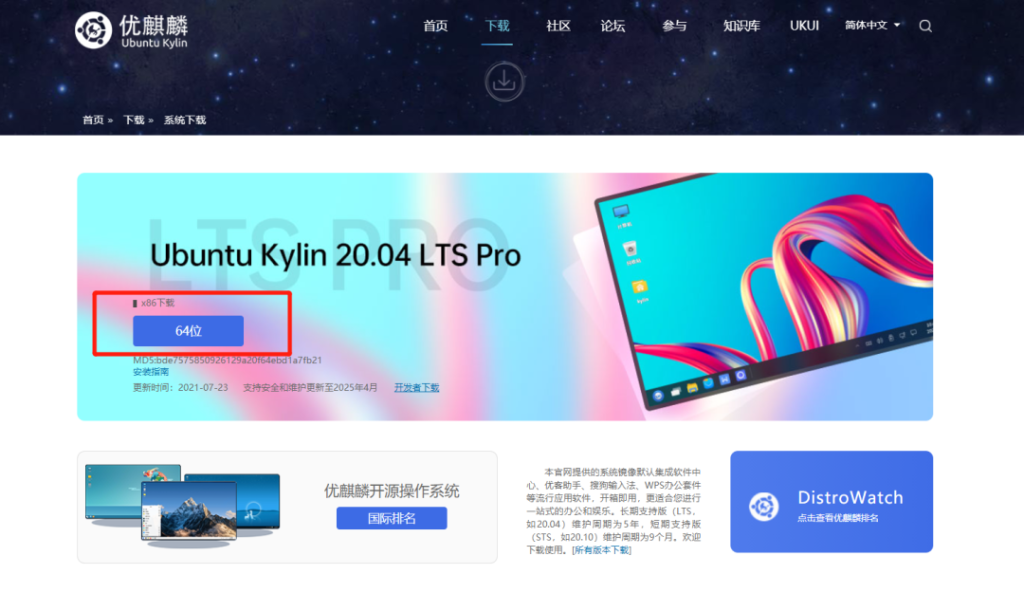

第四步:制作启动盘

此处推荐 Ventoy,下载链接:https://www.lanzoui.com/b01bd54gb

选择结尾为 windows.zip 的最新版本进行下载解压,接着进入解压目录,双击运行 Ventoy2Disk.exe。

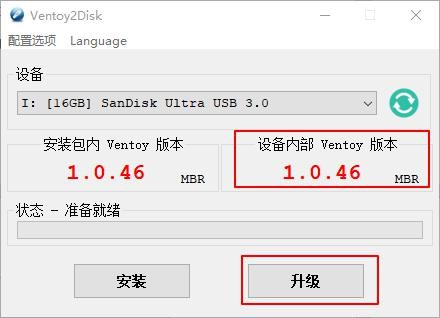

运行界面如下图所示:

① 是插入的 U 盘信息;

② 是此 Ventoy 的版本信息;

③ 是 U 盘内的 Ventoy 版本信息(没有安装 Ventoy 的显示为空);

④ 是安装选项,点击安装,就可以将 Ventoy 安装进对应的 U 盘里;

注:此处安装会提示是否格式化,也就是清空 U 盘内的所有数据,请提前将 U 盘原有数据备份。

安装完成后,设备内部 Ventoy 的版本信息就会显示出来,若内部版本低于安装包版本我们可以点击下方的“升级”选择进行升级。

注:升级操作是安全的,不会让 U 盘里已有的镜像文件丢失。

Ventoy 安装成功后,将优麒麟系统的镜像文件复制进到 U 盘,如下图:

此时 U 盘启动盘已经制作完成。以下为启动界面展示图:

02

安装进行时

三大步

第一步:关闭快速启动

如果不关掉可能会存在无法进入 BIOS 的情况

选择“控制面板–硬件和声音–电源选项–选择电源按钮的功能–更改当前不可用的设置”,在关机设置栏下找到“启动快速启动”,取消勾选,然后点击“保存修改”;

第二步:进行磁盘分区

磁盘分区是为了给优麒麟操作系统分配空间,默认选择分区尾部的磁盘(考虑到机械硬盘的读写特性,尽可能切靠前的分区)

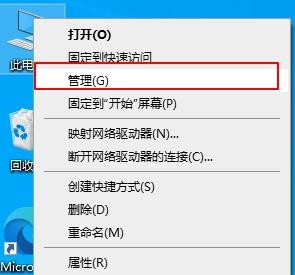

首先需要在 Win10 上创建空白磁盘分区,选择“此电脑”–右键点击“管理”。

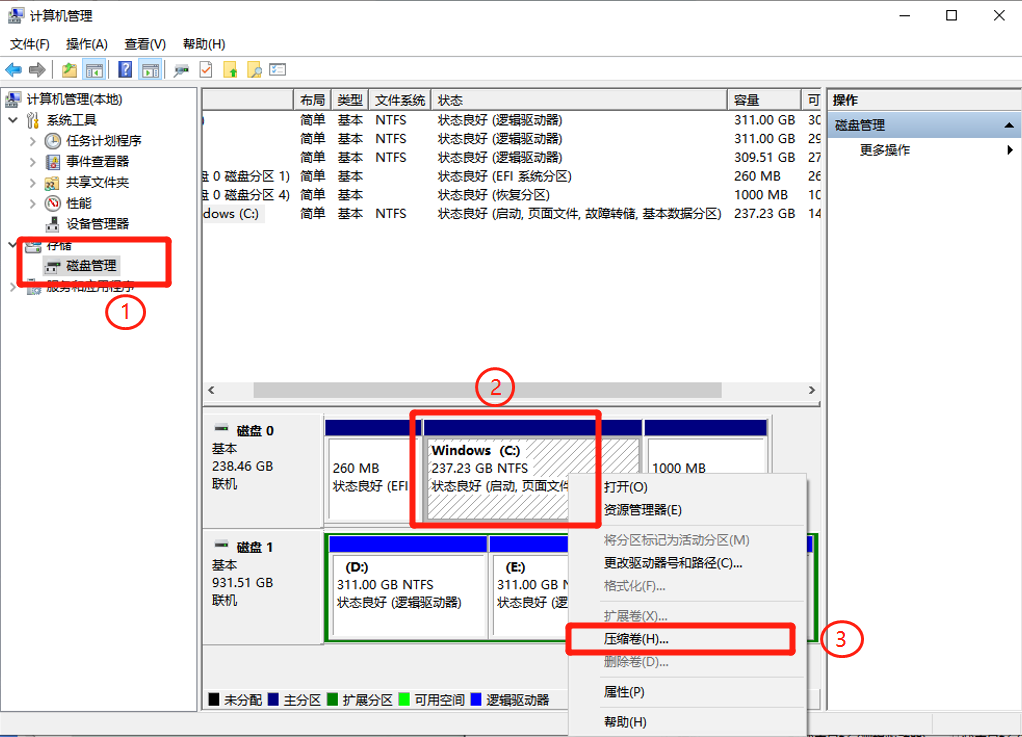

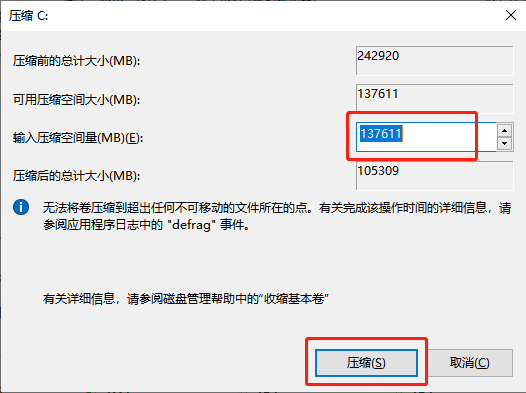

进入“计算机管理”页,点击“存储>磁盘管理”,选择要分割的磁盘空间,右键点击该磁盘,选择“压缩卷”。

此时会弹出压缩窗口,输入压缩空间量的大小,此处展示约分配 135G (空间分配建议最低不少于 30 G,如果大小不够可以重新分配一下磁盘空间,确保分区空余空间充足,原分区的大小也足够使用)。确认压缩空间量后点击“压缩”。

注:1G=1024MB,为方便计算,可以估算成 1G=1000MB。

压缩结束后,会多出一块可用空间,磁盘分区到此结束。

第三步:正式安装

插入制作好的 U 盘启动盘,重启电脑,在开机时按“F2”进入 BIOS 系统,然后在奇奇的带领下,一步步完成双系统的安装吧~

注:根据不同机型进入 BIOS 系统的快捷键有所不同,请根据自身机型搜索对应的快捷键进行操作。

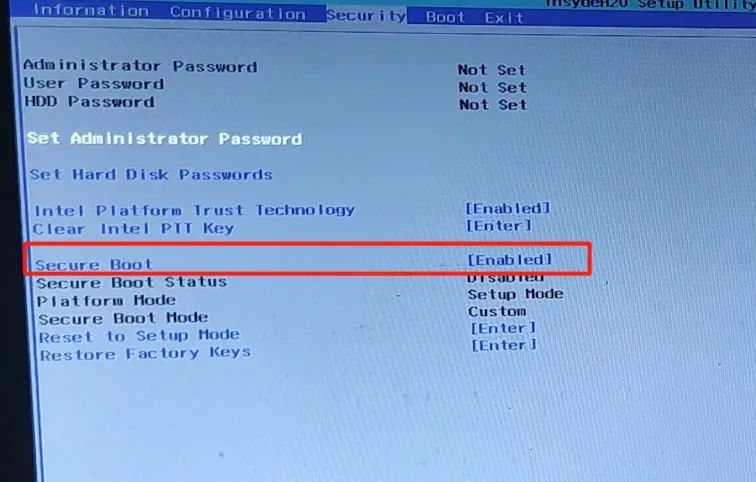

首先关闭安全启动,通过左右方向键进入“Security”界面,按上下方向键移动到“Secure Boot”选项,回车进入修改状态,按上下键选择“Disabled”,回车确认。

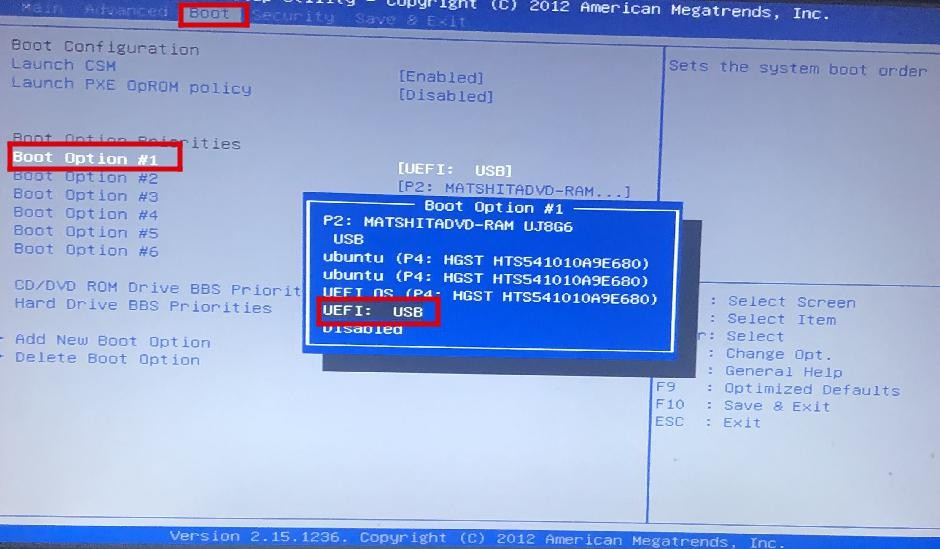

接着通过左右方向键进入“Boot”界面,按上下方向键选择“Boot Option #1”选项卡,回车。选择启动方式为从 USB 启动,即选中自己的 U 盘,回车。

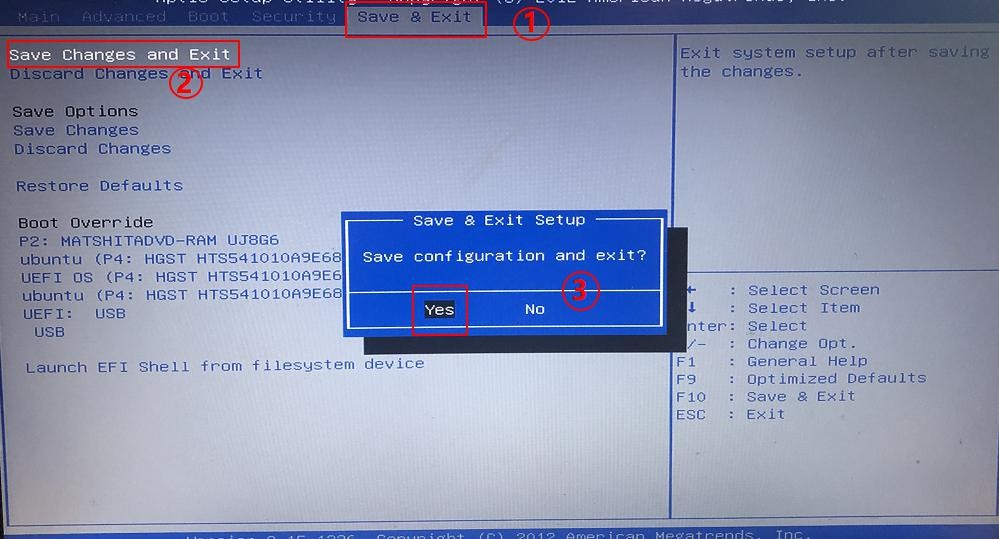

之后通过左右方向键进入“Save & Exit”界面,选择“Save Changes and Exit”,回车。在弹出的选择框里选择“Yes”,回车。

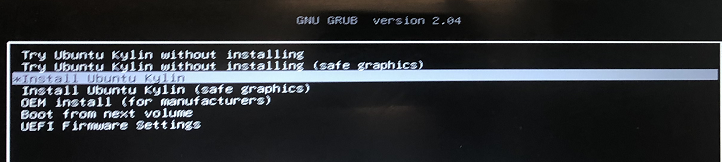

现在电脑开始重新启动,然后你会看到优麒麟开源操作系统安装的准备界面:

稍作等待,进入优麒麟新版安装界面,双击“安装 Kylin”。如下图:

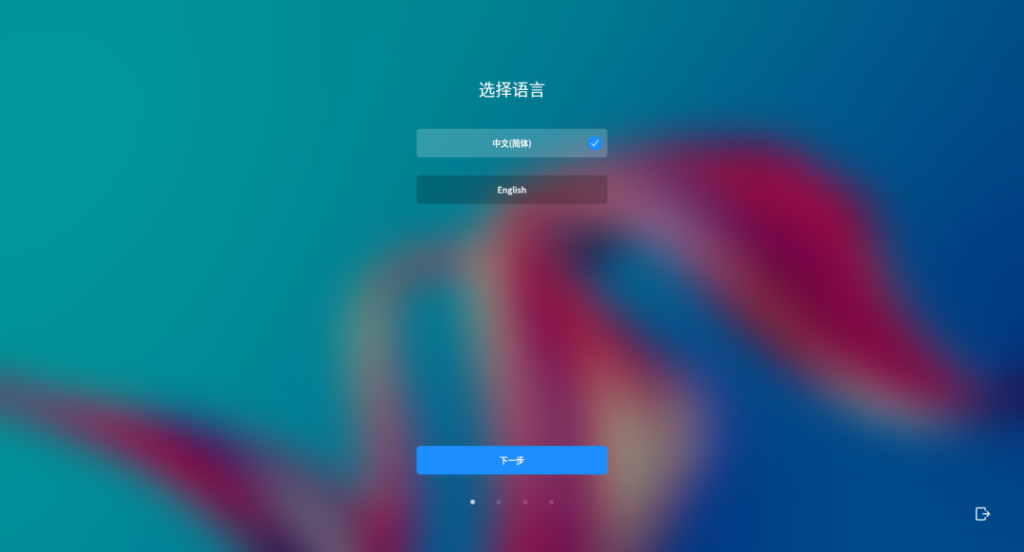

接下来进入安装配置页面–选择语言、时区以及设置用户信息,大家根据自身情况进行设置哦。

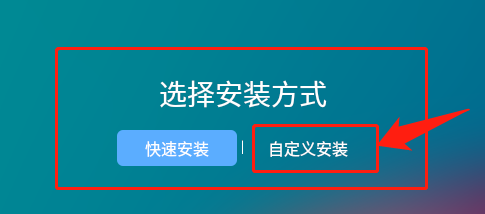

直到出现选择安装方式界面,选择“自定义安装”。

注:记住我们是安装双系统,不要点击快速安装,否则有丢失数据的风险!

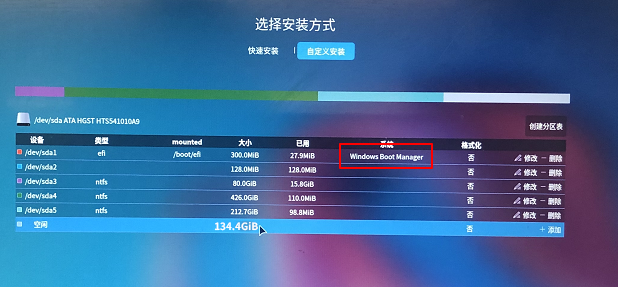

之后进到分区页面,如下图:

可以看到,系统已经存在 Windows 系统,“空闲”对应的就是我们刚刚压缩出来的空闲分区。 因为我们是安装双系统,所以接下来我们要做的就是将优麒麟系统安装在这个空闲分区内。

选中“空闲”分区–点击最右侧的“添加”按钮,进入新建分区页面。

首先添加根分区,奇奇在此处分配的大小是 80G,大家可以根据自身需求进行分配,但一定要确保之后有充足的空间可供使用,如下图:

由于 Windows 系统已经存在 EFI 引导分区了,所以我们再次不用添加 EFI 引导分区。

之后,添加 data 和 backup 分区,作为数据分区和备份还原分区,此处分别分配 20G。

全部分配完成后点击“下一步”,开始安装优麒麟开源操作系统。

等待安装完成,点击“现在重启”。

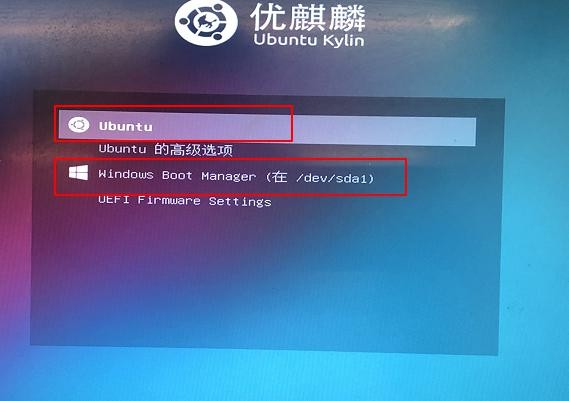

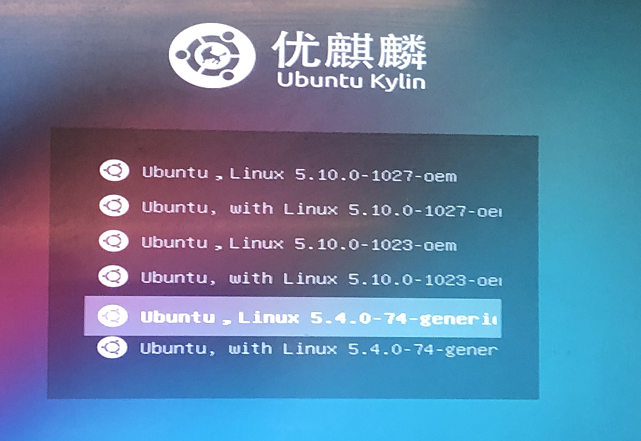

重启后便会出现选择系统界面,如下图:

通过上下键选择我们想要进入的系统,回车。到此,双系统已经安装好啦。

怎么样,你安装成功了吗?

03

常见问题解决方案

希望你用不到

Q:如果双系统安装完成后没有启动项选择界面,该怎么解决?

A:可能是启动项出现问题,可以下载安装用 EasyBCD 软件修复启动项。

Q:配置完分区后提示没有根分区、EFI分区、数据备份或还原分区,该怎么办?

A:根分区对应的是“/”,EFI 分区需要在分区时将“用于”类型改为 EFI,数据备份分区对应的是“/data”,还原分区对应的是“/backup”,请根据提示查找对应的分区是否创建。

Q:配置完分区提示“只能存在一个 EFI 分区”,该怎么办?

A:应该是已有的 Windows 系统也存在 EFI 分区,我们需要把自己添加的 EFI 分区进行删除。

Q:笔记本安装完双系统之后,进入 Windows 系统出现花屏,该怎么办?

A:笔记本只有集显,在系统启动时会先加载优麒麟的显卡驱动以用来加载选择系统的界面,致使在选择进入Windows时出现花屏情况

解决办法:首先,进入优麒麟系统中,打开 /etc/default/grub:

将如下语句取消注释即可(删掉 #)。

# Uncomment to disable graphical terminal (grub-pc only)

# GRUB_TERMINAL=console

Q:使用 USB 启动盘安装时,出现”try ubuntu kylin without installation”或“install ubuntu kylin”,Enter 选择“安装”后,显示器黑屏无任何显示,该怎么办?

A:

方法一:显示黑屏,可能是显卡显示的支持有问题,尝试手动修复。

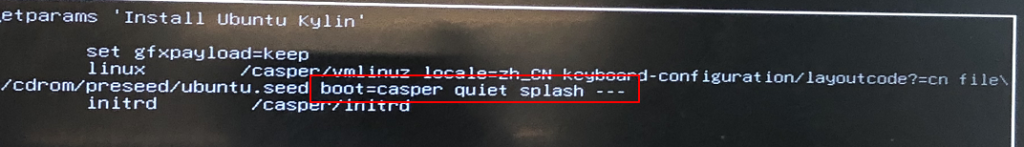

移动光标到”install ubuntu kylin” , 按”e”进入编辑模式,进入命令行模式,

找到”quite splash”然后去掉”—“后,添加“nomodeset”,按 F10 安装。

注:依照不同显卡进行不同显卡驱动选项的添加,此处使用的是Nvidia显卡,添加 nomodeset。

方法二:移动光标到“Try Ubuntu Kylin without installing(safe graphics)”进入安全试用界面尝试使用。

Q:系统安装完成之后,提示未检测到无线网卡,该怎么办?

A:重启,然后在 grub 界面选择高级选项,选择低版本内核,回车,查看网络是否正常:

04

结语

投个票吧投个票吧

如果有什么看不懂的地方,或者在安装过程中出现了文章中未提及的问题,欢迎小伙伴们加入交流群一起探讨,群里不仅有 Linux 忠实爱好者,还有不定时的惊喜福利等你哦~!

扫一扫添加小优微信拉你进群:

llama-b7356-bin-win-cuda-12.4-x64-llama-server参数及使用说明

—– 常见参数 —–

-h, –help, –usage 打印用法并退出

–version 显示版本和构建信息

-cl, –cache-list 显示缓存中的模型列表

–completion-bash 打印可用于源代码的bash补全脚本

–verbose-prompt 在生成前打印详细的提示信息(默认:false)

-t, –threads N 生成期间使用的CPU线程数(默认:-1)

(环境变量:LLAMA_ARG_THREADS)

-tb, –threads-batch N 批处理和提示处理期间使用的线程数(默认:

与–threads相同)

-C, –cpu-mask M CPU亲和性掩码:任意长度的十六进制。与cpu-range互补

(默认:””)

-Cr, –cpu-range lo-hi 用于亲和性的CPU范围。与–cpu-mask互补

–cpu-strict <0|1> 使用严格的CPU放置(默认:0)

–prio N 设置进程/线程优先级:low(-1), normal(0), medium(1), high(2),

realtime(3)(默认:0)

–poll <0…100> 使用轮询级别等待工作(0 – 不轮询,默认:50)

-Cb, –cpu-mask-batch M 批处理的CPU亲和性掩码:任意长度的十六进制。与cpu-range-batch互补

(默认:与–cpu-mask相同)

-Crb, –cpu-range-batch lo-hi 批处理的CPU亲和性范围。与–cpu-mask-batch互补

–cpu-strict-batch <0|1> 使用严格的CPU放置(默认:与–cpu-strict相同)

–prio-batch N 设置进程/线程优先级:0-normal, 1-medium, 2-high, 3-realtime

(默认:0)

–poll-batch <0|1> 使用轮询等待工作(默认:与–poll相同)

-c, –ctx-size N 提示上下文的大小(默认:4096,0 = 从模型加载)

(环境变量:LLAMA_ARG_CTX_SIZE)

-n, –predict, –n-predict N 预测的token数量(默认:-1,-1 = 无限)

(环境变量:LLAMA_ARG_N_PREDICT)

-b, –batch-size N 逻辑最大批处理大小(默认:2048)

(环境变量:LLAMA_ARG_BATCH)

-ub, –ubatch-size N 物理最大批处理大小(默认:512)

(环境变量:LLAMA_ARG_UBATCH)

–keep N 从初始提示中保留的token数量(默认:0,-1 =

全部)

–swa-full 使用完整大小的SWA缓存(默认:false)

[(更多信息)](https://github.com/ggml-org/llama.cpp/pull/13194#issuecomment-2868343055)

(环境变量:LLAMA_ARG_SWA_FULL)

–kv-unified, -kvu 为所有序列的KV缓存使用单一统一的KV缓冲区

(默认:false)

[(更多信息)](https://github.com/ggml-org/llama.cpp/pull/14363)

(环境变量:LLAMA_ARG_KV_UNIFIED)

-fa, –flash-attn [on|off|auto] 设置Flash Attention使用(’on’, ‘off’, 或 ‘auto’, 默认:’auto’)

(环境变量:LLAMA_ARG_FLASH_ATTN)

–no-perf 禁用内部libllama性能计时(默认:false)

(环境变量:LLAMA_ARG_NO_PERF)

-e, –escape 处理转义序列(\n, \r, \t, \’, \”, \\)(默认:true)

–no-escape 不处理转义序列

–rope-scaling {none,linear,yarn} RoPE频率缩放方法,默认为linear除非模型指定

(环境变量:LLAMA_ARG_ROPE_SCALING_TYPE)

–rope-scale N RoPE上下文缩放因子,将上下文扩展N倍

(环境变量:LLAMA_ARG_ROPE_SCALE)

–rope-freq-base N RoPE基础频率,用于NTK感知缩放(默认:从模型加载)

(环境变量:LLAMA_ARG_ROPE_FREQ_BASE)

–rope-freq-scale N RoPE频率缩放因子,将上下文扩展1/N倍

(环境变量:LLAMA_ARG_ROPE_FREQ_SCALE)

–yarn-orig-ctx N YaRN:模型的原始上下文大小(默认:0 = 模型训练

上下文大小)

(环境变量:LLAMA_ARG_YARN_ORIG_CTX)

–yarn-ext-factor N YaRN:外推混合因子(默认:-1.0,0.0 = 全部

插值)

(环境变量:LLAMA_ARG_YARN_EXT_FACTOR)

–yarn-attn-factor N YaRN:缩放sqrt(t)或注意力幅度(默认:-1.0)

(环境变量:LLAMA_ARG_YARN_ATTN_FACTOR)

–yarn-beta-slow N YaRN:高修正维度或alpha(默认:-1.0)

(环境变量:LLAMA_ARG_YARN_BETA_SLOW)

–yarn-beta-fast N YaRN:低修正维度或beta(默认:-1.0)

(环境变量:LLAMA_ARG_YARN_BETA_FAST)

-nkvo, –no-kv-offload 禁用KV卸载

(环境变量:LLAMA_ARG_NO_KV_OFFLOAD)

-nr, –no-repack 禁用权重重新打包

(环境变量:LLAMA_ARG_NO_REPACK)

–no-host 绕过主机缓冲区允许使用额外缓冲区

(环境变量:LLAMA_ARG_NO_HOST)

-ctk, –cache-type-k TYPE K的KV缓存数据类型

允许值:f32, f16, bf16, q8_0, q4_0, q4_1, iq4_nl, q5_0, q5_1

(默认:f16)

(环境变量:LLAMA_ARG_CACHE_TYPE_K)

-ctv, –cache-type-v TYPE V的KV缓存数据类型

允许值:f32, f16, bf16, q8_0, q4_0, q4_1, iq4_nl, q5_0, q5_1

(默认:f16)

(环境变量:LLAMA_ARG_CACHE_TYPE_V)

-dt, –defrag-thold N KV缓存碎片整理阈值(已弃用)

(环境变量:LLAMA_ARG_DEFRAG_THOLD)

-np, –parallel N 解码的并行序列数量(默认:1)

(环境变量:LLAMA_ARG_N_PARALLEL)

–rpc SERVERS 逗号分隔的RPC服务器列表

(环境变量:LLAMA_ARG_RPC)

–mlock 强制系统将模型保留在RAM中而不是交换或压缩

(环境变量:LLAMA_ARG_MLOCK)

–no-mmap 不使用内存映射模型(加载较慢但可能减少页面交换如果未使用mlock)

(环境变量:LLAMA_ARG_NO_MMAP)

–numa TYPE 尝试在某些NUMA系统上优化

– distribute: 均匀分布在所有节点上执行

– isolate: 仅在执行开始的节点的CPU上生成线程

– numactl: 使用numactl提供的CPU映射

如果之前未使用此选项,建议在使用前清空系统页面缓存

请参阅 https://github.com/ggml-org/llama.cpp/issues/1437

(环境变量:LLAMA_ARG_NUMA)

-dev, –device <dev1,dev2,..> 用于卸载的设备列表(none = 不卸载)

使用–list-devices查看可用设备列表

(环境变量:LLAMA_ARG_DEVICE)

–list-devices 打印可用设备列表并退出

–override-tensor, -ot <tensor name pattern>=<buffer type>,…

覆盖张量缓冲区类型

–cpu-moe, -cmoe 将所有专家混合(MoE)权重保留在CPU上

(环境变量:LLAMA_ARG_CPU_MOE)

–n-cpu-moe, -ncmoe N 将前N层的专家混合(MoE)权重保留在CPU上

(环境变量:LLAMA_ARG_N_CPU_MOE)

-ngl, –gpu-layers, –n-gpu-layers N 存储在VRAM中的最大层数(默认:-1)

(环境变量:LLAMA_ARG_N_GPU_LAYERS)

-sm, –split-mode {none,layer,row} 如何在多个GPU之间拆分模型,以下之一:

– none: 仅使用一个GPU

– layer(默认): 在GPU之间拆分层和KV

– row: 在GPU之间拆分行

(环境变量:LLAMA_ARG_SPLIT_MODE)

-ts, –tensor-split N0,N1,N2,… 每个GPU卸载模型的比例,逗号分隔的比例列表,例如3,1

(环境变量:LLAMA_ARG_TENSOR_SPLIT)

-mg, –main-gpu INDEX 使用的GPU(split-mode = none时),或用于

中间结果和KV(split-mode = row时)(默认:0)

(环境变量:LLAMA_ARG_MAIN_GPU)

–check-tensors 检查模型张量数据中的无效值(默认:false)

–override-kv KEY=TYPE:VALUE 高级选项,通过键覆盖模型元数据。可以多次指定。

类型:int, float, bool, str。示例:–override-kv

tokenizer.ggml.add_bos_token=bool:false

–no-op-offload 禁用将主机张量操作卸载到设备(默认:false)

–lora FNAME LoRA适配器路径(可重复使用多个适配器)

–lora-scaled FNAME SCALE 带用户定义缩放的LoRA适配器路径(可重复使用多个适配器)

–control-vector FNAME 添加控制向量

注意:此参数可以重复添加多个控制向量

–control-vector-scaled FNAME SCALE 添加带用户定义缩放SCALE的控制向量

注意:此参数可以重复添加多个缩放控制向量

–control-vector-layer-range START END

应用控制向量的层范围,包括起始和结束

-m, –model FNAME 加载模型的路径

(环境变量:LLAMA_ARG_MODEL)

-mu, –model-url MODEL_URL 模型下载URL(默认:未使用)

(环境变量:LLAMA_ARG_MODEL_URL)

-dr, –docker-repo [<repo>/]<model>[:quant]

Docker Hub模型仓库。repo是可选的,默认为ai/. quant

是可选的,默认为:latest.

示例:gemma3

(默认:未使用)

(环境变量:LLAMA_ARG_DOCKER_REPO)

-hf, -hfr, –hf-repo <user>/<model>[:quant]

Hugging Face模型仓库;quant是可选的,不区分大小写,

默认为Q4_K_M,或如果Q4_K_M不存在,则回退到仓库中的第一个文件。

如果可用,mmproj也会自动下载。要禁用,请添加

–no-mmproj

示例:unsloth/phi-4-GGUF:q4_k_m

(默认:未使用)

(环境变量:LLAMA_ARG_HF_REPO)

-hfd, -hfrd, –hf-repo-draft <user>/<model>[:quant]

与–hf-repo相同,但用于草稿模型(默认:未使用)

(环境变量:LLAMA_ARG_HFD_REPO)

-hff, –hf-file FILE Hugging Face模型文件。如果指定,将覆盖–hf-repo中的quant(默认:未使用)

(环境变量:LLAMA_ARG_HF_FILE)

-hfv, -hfrv, –hf-repo-v <user>/<model>[:quant]

语音编码器模型的Hugging Face模型仓库(默认:未使用)

(环境变量:LLAMA_ARG_HF_REPO_V)

-hffv, –hf-file-v FILE 语音编码器模型的Hugging Face模型文件(默认:未使用)

(环境变量:LLAMA_ARG_HF_FILE_V)

-hft, –hf-token TOKEN Hugging Face访问令牌(默认:来自HF_TOKEN环境

变量)

(环境变量:HF_TOKEN)

–log-disable 禁用日志

–log-file FNAME 日志到文件

(环境变量:LLAMA_LOG_FILE)

–log-colors [on|off|auto] 设置彩色日志(’on’, ‘off’, 或 ‘auto’, 默认:’auto’)

‘auto’ 在输出到终端时启用颜色

(环境变量:LLAMA_LOG_COLORS)

-v, –verbose, –log-verbose 设置详细级别为无限(即记录所有消息,适用于

调试)

–offline 离线模式:强制使用缓存,防止网络访问

(环境变量:LLAMA_OFFLINE)

-lv, –verbosity, –log-verbosity N 设置详细级别阈值。详细级别更高的消息将被忽略。值:

– 0: 通用输出

– 1: 错误

– 2: 警告

– 3: 信息

– 4: 调试

(默认:3)

(环境变量:LLAMA_LOG_VERBOSITY)

–log-prefix 在日志消息中启用前缀

(环境变量:LLAMA_LOG_PREFIX)

–log-timestamps 在日志消息中启用时间戳

(环境变量:LLAMA_LOG_TIMESTAMPS)

-ctkd, –cache-type-k-draft TYPE 草稿模型K的KV缓存数据类型

允许值:f32, f16, bf1线, q8_0, q4_0, q4_1, iq4_nl, q5_0, q5_1

(默认:f16)

(环境变量:LLAMA_ARG_CACHE_TYPE_K_DRAFT)

-ctvd, –cache-type-v-draft TYPE 草稿模型V的KV缓存数据类型

允许值:f32, f16, bf16, q8_0, q4_0, q4_1, iq4_nl, q5_0, q5_1

(默认:f16)

(环境变量:LLAMA_ARG_CACHE_TYPE_V_DRAFT)

—– 采样 params —–

–samplers SAMPLERS 生成过程中按顺序使用的采样器,用分号分隔

(默认:

penalties;dry;top_n_sigma;top_k;typ_p;top_p;min_p;xtc;temperature)

-s, –seed SEED RNG种子(默认:-1,-1时使用随机种子)

–sampling-seq, –sampler-seq SEQUENCE

用于生成的采样器简化序列(默认:

edskypmxt)

–ignore-eos 忽略流结束标记并继续生成(意味着

–logit-bias EOS-inf)

–temp N 温度(默认:0.8)

–top-k N top-k采样(默认:40,0 = 禁用)

–top-p N top-p采样(默认:0.9,1.0 = 禁用)

–min-p N min-p采样(默认:0.1,0.0 = 禁用)

–top-nsigma N top-n-sigma采样(默认:-1.0,-1.0 = 禁用)

–xtc-probability N xtc概率(默认:0.0,0.0 = 禁用)

–xtc-threshold N xtc阈值(默认:0.1,1.0 = 禁用)

–typical N 本地典型采样,参数p(默认:1.0,1.0 = 禁用)

–repeat-last-n N 用于惩罚的最后n个token(默认:64,0 = 禁用,-1

= ctx_size)

–repeat-penalty N 对重复的token序列进行惩罚(默认:1.0,1.0 = 禁用)

–presence-penalty N 重复alpha存在惩罚(默认:0.0,0.0 = 禁用)

–frequency-penalty N 重复alpha频率惩罚(默认:0.0,0.0 = 禁用)

–dry-multiplier N 设置DRY采样乘数(默认:0.0,0.0 = 禁用)

–dry-base N 设置DRY采样基础值(默认:1.75)

–dry-allowed-length N 设置DRY采样允许长度(默认:2)

–dry-penalty-last-n N 设置最后n个token的DRY惩罚(默认:-1,0 = 禁用,-1 =

context size)

–dry-sequence-breaker STRING 为DRY采样添加序列终止符,同时清除默认终止符

(’\n’, ‘:’, ‘”‘, ‘*’);使用”none”表示不使用任何

序列终止符

–dynatemp-range N 动态温度范围(默认:0.0,0.0 = 禁用)

–dynatemp-exp N 动态温度指数(默认:1.0)

–mirostat N 使用Mirostat采样。

如果使用,将忽略Top K、Nucleus和本地典型采样器。

(默认:0,0 = 禁用,1 = Mirostat,2 = Mirostat 2.0)

–mirostat-lr N Mirostat学习率,参数eta(默认:0.1)

–mirostat-ent N Mirostat目标熵,参数tau(默认:5.0)

-l, –logit-bias TOKEN_ID(+/-)BIAS 修改token在完成中出现的可能性,

例如 `–logit-bias 15043+1` 增加token ‘ Hello’ 出现的可能性,

或 `–logit-bias 15043-1` 减少token ‘ Hello’ 出现的可能性

–grammar GRAMMAR 用于约束生成的类似BNF的语法(参见grammars/

目录中的示例)(默认:”)

–grammar-file FNAME 从文件读取语法

-j, –json-schema SCHEMA 用于约束生成的JSON模式(https://json-schema.org/),例如

`{}` 表示任何JSON对象

对于包含外部$ref的模式,请使用 –grammar +

example/json_schema_to_grammar.py

-jf, –json-schema-file FILE 包含用于约束生成的JSON模式的文件

(https://json-schema.org/),例如 `{}` 表示任何JSON对象

对于包含外部$ref的模式,请使用 –grammar +

example/json_schema_to_grammar.py

—– 示例特定参数 —–

–ctx-checkpoints, –swa-checkpoints N

每个插槽创建的上下文检查点的最大数量(默认:8)

[(更多信息)](https://github.com/ggml-org/llama.cpp/pull/15293)

(env: LLAMA_ARG_CTX_CHECKPOINTS)

–cache-ram, -cram N 设置最大缓存大小(单位:MiB)(默认:8192,-1 – 无限制,0 – 禁用)

[(更多信息)](https://github.com/ggml-org/llama.cpp/pull/16391)

(env: LLAMA_ARG_CACHE_RAM)

–no-context-shift 在无限文本生成中禁用上下文切换(默认:启用)

(env: LLAMA_ARG_NO_CONTEXT_SHIFT)

–context-shift 在无限文本生成中启用上下文切换(默认:禁用)

(env: LLAMA_ARG_CONTEXT_SHIFT)

-r, –reverse-prompt PROMPT 在 PROMPT 处停止生成,返回控制权至交互模式

-sp, –special 启用特殊标记输出(默认:false)

–no-warmup 跳过使用空运行预热模型

–spm-infill 使用后缀/前缀/中间模式进行填充(而非前缀/后缀/中间模式),某些模型更偏好此方式(默认:禁用)

–pooling {none,mean,cls,last,rank} 嵌入向量的池化类型,未指定时使用模型默认值

(env: LLAMA_ARG_POOLING)

-cb, –cont-batching 启用连续批处理(又称动态批处理)(默认:启用)

(env: LLAMA_ARG_CONT_BATCHING)

-nocb, –no-cont-batching 禁用连续批处理

(env: LLAMA_ARG_NO_CONT_BATCHING)

–mmproj FILE 多模态投影器文件路径。参见 tools/mtmd/README.md

注意:如果使用 -hf,可省略此参数

(env: LLAMA_ARG_MMPROJ)

–mmproj-url URL 多模态投影器文件的 URL。参见 tools/mtmd/README.md

(env: LLAMA_ARG_MMPROJ_URL)

–no-mmproj 显式禁用多模态投影器,适用于使用 -hf 的情况

(env: LLAMA_ARG_NO_MMPROJ)

–no-mmproj-offload 不将多模态投影器卸载到 GPU

(env: LLAMA_ARG_NO_MMPROJ_OFFLOAD)

–image-min-tokens N 每张图像可占用的最小标记数,仅用于具有动态分辨率的视觉模型(默认:从模型读取)

(env: LLAMA_ARG_IMAGE_MIN_TOKENS)

–image-max-tokens N 每张图像可占用的最大标记数,仅用于具有动态分辨率的视觉模型(默认:从模型读取)

(env: LLAMA_ARG_IMAGE_MAX_TOKENS)

–override-tensor-draft, -otd <tensor name pattern>=<buffer type>,…

为草稿模型覆盖张量缓冲区类型

–cpu-moe-draft, -cmoed 将草稿模型的所有专家混合(MoE)权重保留在 CPU 中

(env: LLAMA_ARG_CPU_MOE_DRAFT)

–n-cpu-moe-draft, -ncmoed N 将草稿模型前 N 层的 MoE 权重保留在 CPU 中

(env: LLAMA_ARG_N_CPU_MOE_DRAFT)

-a, –alias STRING 为模型名称设置别名(供 REST API 使用)

(env: LLAMA_ARG_ALIAS)

–host HOST 监听的 IP 地址,或若地址以 .sock 结尾则绑定到 UNIX 套接字(默认:127.0.0.1)

(env: LLAMA_ARG_HOST)

–port PORT 监听端口(默认:8080)

(env: LLAMA_ARG_PORT)

–path PATH 提供静态文件的路径(默认:)

(env: LLAMA_ARG_STATIC_PATH)

–api-prefix PREFIX 服务器服务的前缀路径(不带尾部斜杠)

(默认:)

(env: LLAMA_ARG_API_PREFIX)

–no-webui 禁用 Web UI(默认:启用)

(env: LLAMA_ARG_NO_WEBUI)

–embedding, –embeddings 仅支持嵌入用例;仅与专用嵌入模型一起使用(默认:禁用)

(env: LLAMA_ARG_EMBEDDINGS)

–reranking, –rerank 启用服务器的重排序端点(默认:禁用)

(env: LLAMA_ARG_RERANKING)

–api-key KEY 认证使用的 API 密钥(默认:无)

(env: LLAMA_API_KEY)

–api-key-file FNAME 包含 API 密钥的文件路径(默认:无)

–ssl-key-file FNAME PEM 编码 SSL 私钥文件路径

(env: LLAMA_ARG_SSL_KEY_FILE)

–ssl-cert-file FNAME PEM 编码 SSL 证书文件路径

(env: LLAMA_ARG_SSL_CERT_FILE)

–chat-template-kwargs STRING 为 JSON 模板解析器设置附加参数

(env: LLAMA_CHAT_TEMPLATE_KWARGS)

-to, –timeout N 服务器读/写超时时间(秒)(默认:600)

(env: LLAMA_ARG_TIMEOUT)

–threads-http N 处理 HTTP 请求的线程数(默认:-1)

(env: LLAMA_ARG_THREADS_HTTP)

–cache-reuse N 尝试通过 KV 切换从缓存中重用的最小块大小(默认:0)

[(卡片)](https://ggml.ai/f0.png)

(env: LLAMA_ARG_CACHE_REUSE)

–metrics 启用 Prometheus 兼容的指标端点(默认:禁用)

(env: LLAMA_ARG_ENDPOINT_METRICS)

–props 启用通过 POST /props 更改全局属性(默认:禁用)

(env: LLAMA_ARG_ENDPOINT_PROPS)

–slots 启用插槽监控端点(默认:启用)

(env: LLAMA_ARG_ENDPOINT_SLOTS)

–no-slots 禁用插槽监控端点

(env: LLAMA_ARG_NO_ENDPOINT_SLOTS)

–slot-save-path PATH 保存插槽 KV 缓存的路径(默认:禁用)

–media-path PATH 用于加载本地媒体文件的目录;文件可通过 file:// URL 使用相对路径访问(默认:禁用)

–models-dir PATH 路由器服务器包含模型的目录(默认:禁用)

(env: LLAMA_ARG_MODELS_DIR)

–models-preset PATH 包含路由器服务器模型预设的 INI 文件路径(默认:禁用)

(env: LLAMA_ARG_MODELS_PRESET)

–models-max N 路由器服务器同时加载模型的最大数量(默认:4,0 = 无限制)

(env: LLAMA_ARG_MODELS_MAX)

–no-models-autoload 禁用模型的自动加载(默认:启用)

(env: LLAMA_ARG_NO_MODELS_AUTOLOAD)

–jinja 使用 Jinja 模板进行聊天(默认:启用)

(env: LLAMA_ARG_JINJA)

–no-jinja 禁用 Jinja 模板进行聊天(默认:禁用)

(env: LLAMA_ARG_NO_JINJA)

–reasoning-format FORMAT 控制是否允许提取响应中的思考标记以及返回格式;可选值:

– none: 保留 thoughts 未解析在 `message.content` 中

– deepseek: 将 thoughts 放入 `message.reasoning_content` 中

– deepseek-legacy: 在 `message.content` 中保留 `think` 标记,同时填充 `message.reasoning_content`

(默认:auto)

(env: LLAMA_ARG_THINK)

–reasoning-budget N 控制允许的思考量;目前仅支持:-1 表示无限制,0 表示禁用思考(默认:-1)

(env: LLAMA_ARG_THINK_BUDGET)

–chat-template JINJA_TEMPLATE 设置自定义 Jinja 聊天模板(默认:从模型元数据中获取模板)

如果指定了后缀/前缀,模板将被禁用

仅接受常用模板(除非在该标志前设置了 –jinja):

内置模板列表:

bailing, bailing-think, bailing2, chatglm3, chatglm4, chatml,

command-r, deepseek, deepseek2, deepseek3, exaone3, exaone4, falcon3,

gemma, gigachat, glmedge, gpt-oss, granite, grok-2, hunyuan-dense,

hunyuan-moe, kimi-k2, llama2, llama2-sys, llama2-sys-bos,

llama2-sys-strip, llama3, llama4, megrez, minicpm, mistral-v1,

mistral-v3, mistral-v3-tekken, mistral-v7, mistral-v7-tekken, monarch,

openchat, orion, pangu-embedded, phi3, phi4, rwkv-world, seed_oss,

smolvlm, vicuna, vicuna-orca, yandex, zephyr

(env: LLAMA_ARG_CHAT_TEMPLATE)

–chat-template-file JINJA_TEMPLATE_FILE

设置自定义 Jinja 聊天模板文件(默认:从模型元数据中获取模板)

如果指定了后缀/前缀,模板将被禁用

仅接受常用模板(除非在该标志前设置了 –jinja):

内置模板列表:

bailing, bailing-think, bailing2, chatglm3, chatglm4, chatml,

command-r, deepseek, deepseek2, deepseek3, exaone3, exaone4, falcon3,

gemma, gigachat, glmedge, gpt-oss, granite, grok-2, hunyuan-dense,

hunyuan-moe, kimi-k2, llama2, llama2-sys, llama2-sys-bos,

llama2-sys-strip, llama3, llama4, megrez, minicpm, mistral-v1,

mistral-v3, mistral-v3-tekken, mistral-v7, mistral-v7-tekken, monarch,

openchat, orion, pangu-embedded, phi3, phi4, rwkv-world, seed_oss,

smolvlm, vicuna, vicuna-orca, yandex, zephyr

(env: LLAMA_ARG_CHAT_TEMPLATE_FILE)

–no-prefill-assistant 如果最后一条消息是助理消息,是否预填充助理的响应(默认:启用预填充)

当设置此标志时,如果最后一条消息是助理消息,将视为完整消息并禁用预填充

(env: LLAMA_ARG_NO_PREFILL_ASSISTANT)

-sps, –slot-prompt-similarity SIMILARITY

请求的提示与插槽提示匹配的相似度阈值,以使用该插槽(默认:0.10,0.0 = 禁用)

–lora-init-without-apply 加载 LoRA 适配器但不立即应用(稍后通过 POST /lora-adapters 应用)(默认:禁用)

-td, –threads-draft N 生成期间使用的线程数(默认:与 –threads 相同)

-tbd, –threads-batch-draft N 批处理和提示处理期间使用的线程数(默认:与 –threads-draft 相同)

–draft-max, –draft, –draft-n N 用于推测解码的草稿标记数(默认:16)

(env: LLAMA_ARG_DRAFT_MAX)

–draft-min, –draft-n-min N 用于推测解码的最小草稿标记数(默认:0)

(env: LLAMA_ARG_DRAFT_MIN)

–draft-p-min P 最小推测解码概率(贪婪)(默认:0.8)

(env: LLAMA_ARG_DRAFT_P_MIN)

-cd, –ctx-size-draft N 草稿模型的提示上下文大小(默认:0,0 = 从模型加载)

(env: LLAMA_ARG_CTX_SIZE_DRAFT)

-devd, –device-draft <dev1,dev2,..> 用于卸载草稿模型的设备列表(逗号分隔)(none = 不卸载)

使用 –list-devices 查看可用设备列表

-ngld, –gpu-layers-draft, –n-gpu-layers-draft N

为草稿模型存储在 VRAM 中的层数

(env: LLAMA_ARG_N_GPU_LAYERS_DRAFT)

-md, –model-draft FNAME 用于推测解码的草稿模型(默认:未使用)

(env: LLAMA_ARG_MODEL_DRAFT)

–spec-replace TARGET DRAFT 如果草稿模型和主模型不兼容,将 TARGET 中的字符串转换为 DRAFT

-mv, –model-vocoder FNAME 用于音频生成的声码器模型(默认:未使用)

–tts-use-guide-tokens 使用引导标记提高 TTS 词汇召回率

–embd-gemma-default 使用默认 EmbeddingGemma 模型(注意:可从互联网下载权重)

–fim-qwen-1.5b-default 使用默认 Qwen 2.5 Coder 1.5B(注意:可从互联网下载权重)

–fim-qwen-3b-default 使用默认 Qwen 2.5 Coder 3B(注意:可从互联网下载权重)

–fim-qwen-7b-default 使用默认 Qwen 2.5 Coder 7B(注意:可从互联网下载权重)

–fim-qwen-7b-spec 使用 Qwen 2.5 Coder 7B + 0.5B 草稿进行推测解码(注意:可从互联网下载权重)

–fim-qwen-14b-spec 使用 Qwen 2.5 Coder 14B + 0.5B 草稿进行推测解码(注意:可从互联网下载权重)

–fim-qwen-30b-default 使用默认 Qwen 3 Coder 30B A3B Instruct(注意:可从互联网下载权重)

–gpt-oss-20b-default 使用 gpt-oss-20b(注意:可从互联网下载权重)

–gpt-oss-120b-default 使用 gpt-oss-120b(注意:可从互联网下载权重)

–vision-gemma-4b-default 使用 Gemma 3 4B QAT(注意:可从互联网下载权重)

–vision-gemma-12b-default 使用 Gemma 3 12B QAT(注意:可从互联网下载权重)